![]()

0

บทความโดย :

ดร. มนต์ศักดิ์ โซ่เจริญธรรม

https://www.facebook.com/monsaks

0

จากเหตุการณ์ในคดีของ George Floyd ที่เป็นประเด็นเรื่องเรื่องการปฏิบัติที่ไม่เท่าเทียมกันในสังคม (Discrimination) จนกลายเป็นปัญหาความเหลือมล้ำทางด้านผิวสีที่นำไปสู่การประท้วงใหญ่ในสหรัฐอเมริกา ได้ลุกลามนำมาสู่เรื่องของความเหลื่อมล้ำของเทคโนโลยี AI ในการจำแนกใบหน้าบุคคลผิวสี จนเกิดเหตุการณ์ ดังนี้

– IBM ประกาศยกเลิกการทำธุรกิจ การพัฒนา และการวิจัยเทคโนโลยีรู้จำใบหน้า (Facial Recognition)

– Microsoft ประกาศว่าจะไม่ขายเทคโนโลยีรู้จำใบหน้าให้กับตำรวจจนกว่ารัฐสภาสหรัฐฯ จะผ่านกฎหมายคุ้มครองดูแลข้อมูลส่วนบุคคล ไม่ให้เกิดการเลือกปฏิบัติและแบ่งแยก

– Amazon ประกาศหยุดสนับสนุนการใช้เทคโนโลยีรู้จำใบหน้าแก่ตำรวจ เป็นเวลา 1 ปี

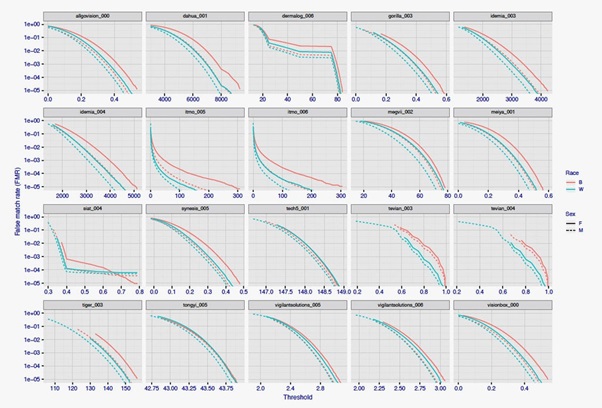

โดยเรื่องความเหลื่อมล้ำของ AI ในการจำแนกใบหน้าบุคคลผิวสีนี้ไม่ใช่ไม่มีมูล เพราะสถาบันมาตรฐานและเทคโนโลยีแห่งชาติของอเมริกา (NIST – National Institute of Standards and Technology) ได้ทำการทดสอบความแม่นยำของอัลกอริธึมในการจำแนกบุคคลด้วยเทคโนโลยีรู้จำใบหน้าของหลายสิบบริษัททั่วโลก ซึ่งพบว่ามันมีความเลื่อมล้ำเกิดขึ้นกับเทคโนโลยีนี้จริง

การจัดคู่ภาพผิด หรือ Mugshots คือ เรามีภาพของบุคคลต้องสงสัย แล้วต้องการเอาไปหาคู่เทียบภาพของคนเดียวกันที่มีอยู่แล้วในฐานข้อมูล เช่น ฐานข้อมูลผู้ต้องสงสัย ส่วน False Match Rate คือ อัตราที่จับหาคู่ภาพขึ้นมาแล้วผิด ซึ่งปกติค่าที่ยอมรับได้คือ 1/10,000 แต่ในผลการทดสอบ NIST บอกว่า ในช่วงปี 2010-2018 ความแม่นยำในการทำ Facial Recognition ดีขึ้นถึง 25 เท่า และมีโอกาสผิดพลาดเพียงแค่ 0.2% เท่านั้น แต่อย่างไรก็ตาม เมื่อมีการทดสอบโดยเทียบเจาะจงเฉพาะคนผิวขาวกับคนผิวสี และผู้ชายกับผู้หญิง พบว่า

– กรณีหญิงผิวขาว จะมีอัตราการจับคู่ภาพถ่ายกับภาพจากฐานข้อมูลผิดที่ 1/10,000 แต่หญิงผิวสีจะเป็น 1/1,000 ซึ่งหมายความว่าในกรณีของหญิงผิวสีจะมีอัตราความผิดพลาดมากกว่าหญิงผิวขาวถึง 10 เท่า

– การประมวลผลภาพของผู้หญิงมีโอกาสผิดมากกว่าผู้ชาย ซึ่งยังไม่ทราบสาเหตุที่แน่นอน แต่สันนิษฐานว่าอาจเป็นเพราะผู้หญิงแต่ละคนแต่งหน้ามากบ้างน้อยบ้าง สไตล์ก็ต่างกันบ้าง จึงทำให้ยากกว่า

– ผลการทดสอบล่าสุดในปีนี้ ยังคงออกมาในทิศทางเดียวกัน คือ ภาพของคนผิวสี กับกับภาพของคนผิวขาว โอกาสที่จะเกิดความผิดพลาดต่างกัน 5-10 แล้วแต่ยี่ห้ออัลกอริธึม ตรงนี้ศัพท์เทคนิคเรียก False Match Rate (FMR) คือ เจอภาพในฐานข้อมูลแต่ภาพนั้นไม่ใช่ของบุคคลนั้นจริงๆ

นอกจากสถาบัน NIST แล้ว ยังมีสถาบันอื่นๆ อีกหลายแหล่งที่ทำการทดสอบ เช่น สหภาพเสรีภาพพลเมืองอเมริกัน (ACLU – The American Civil Liberties Union) ซึ่งเคยนำภาพใบหน้าของสมาชิกวุฒิสภาสหรัฐฯ 535 คน ประกอบด้วย สส. 435 คน และ สว. อีก 100 คน มาลองหาว่าจะแมทช์ตรงกับภาพหน้าคนร้ายคนใดหรือไม่ในฐานข้อมูล Mugshots (ภาพหน้าคนร้ายในอเมริกาที่เป็นข้อมูลสาธารณะ) โดยใช้เทคโนโลยี AI รู้จำใบหน้าของบริษัท Amazon ผลปรากฏว่ามีสส.และสว.กว่า 28 คน ที่ใบหน้าโดนแมทช์เข้ากับฐานข้อมูลใบหน้าคนร้ายตามหมายจับ

ในกรณีนี้ หากอ้างอิงกฎหมายคุ้มครองข้อมูลส่วนบุคคล GDPR ของทางฝั่งของยุโรป ในส่วนของจรรยาบรรณ AI หรือ AI Ethics ระบุว่าหากใช้ AI ในการประมวลผล จะต้องให้ผลที่เท่าเทียมกันและไม่เลือกปฏิบัติ ซึ่งในกรณีที่ผลการรู้จำภาพใบหน้าของคนผิวสีที่ต่างคนขาวประมาณ 10 นี้ ถือว่าเกิดความเหลื่อมล้ำอย่างชัดเจน โดยเฉพาะเมื่อมีการนำมาใช้ประกอบการตัดสินที่มีผลทางกฎหมาย หรือนำมาเกี่ยวข้องกับบริการสำคัญต่างๆ

ท่านที่สนใจวิธีการทดสอบ การเตรียมข้อมูลสำหรับทดสอบ และผลอย่างละเอียด สามารถเข้าไปดูได้ที่ – https://www.nist.gov/programs-projects/face-recognition-vendor-test-frvt-ongoing

อ้างอิง

https://www.cnet.com/news/amazon-announces-one-year-pause-on-facial-recognition-for-police/

https://ec.europa.eu/digital-single-market/en/news/ethics-guidelines-trustworthy-ai

ขอขอบคุณแหล่งที่มา :

https://www.facebook.com/monsaks/posts/3533855819961365

เรียบเรียงโดย : บรรณาธิการ Security Systems Magazine